Google I/O 2023 : ce que l’on retient

L’événement de cette année ne pouvait qu’être placé sous le signe de l’IA et des progrès responsables concrets et théoriques de Google sur le sujet. Une façon de répondre directement à l’offensive d’OpenAI / Microsoft développée depuis 6 mois. Tour d’horizon des principales nouvelles qui ont retenu notre attention.

L’IA embarquée dans les produits de Google

Duet AI pour Google Cloud

Google a présenté son assistant chatbot Duet, qui aide les développeurs – et les non-développeurs – à utiliser ses services de Cloud Computing.

Tout en travaillant dans la Console Cloud de Google, les utilisateurs peuvent poser des questions sur les services disponibles et recevoir des réponses au sein de la console. Il est donc moins nécessaire d’aller chercher des informations ailleurs en ligne.

Google suit Amazon et Microsoft sur le marché du Cloud public, mais aucun de ses principaux rivaux n’a publié de chatbot capable de faire ce que Duet AI peut accomplir selon Google… À suivre.

Duet AI dans Google Workspace

- La fonctionnalité Help Me Write de Google permet désormais de rédiger des dissertations, des argumentaires de vente ou encore des offres d’emploi, le tout avec un niveau de qualité professionnel. Une correction orthographique, grammaticale et syntaxique améliorée, non seulement en anglais, mais aussi en espagnol, en français, en japonais, etc. sera incluse dans Google Docs pour tous.

- Duet AI dans Google Sheets promet d’aider les utilisateurs à analyser et à agir sur leurs données « plus rapidement que jamais », grâce à la classification automatisée des données et à la création de plans personnalisés. En d’autres termes, Google Sheets permettra désormais de transformer des idées en actions et des données en informations.

- Embarqué dans Slides, Duet AI peut, selon Google, générer des images à l’intérieur même de l’application.

Tailwind : l’«IA personnalisée »

Ce nouveau projet permettra à chacun de bénéficier d’une IA qui pourra rédiger des notes personnalisées (à la manière d’un Notebook), en s’appuyant sur les documents internes qu’on lui mettra à disposition. Elle pourra ainsi citer des sources provenant non pas du web, mais de documents propres à chaque personne.

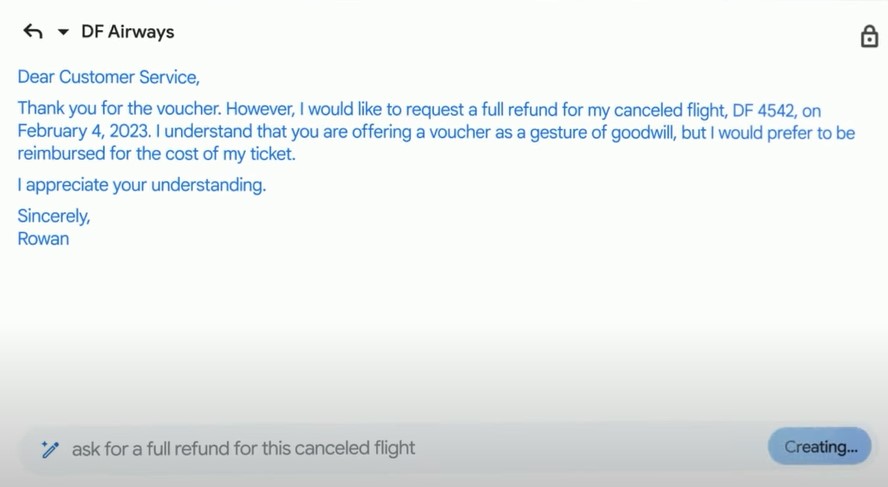

Génération de contenus dans Gmail

La rédaction assistée d’e-mails comptait parmi les premiers exemples présentés durant la conférence. L’idée est de confier à l’IA, via un prompt rapide, la création de messages. Pour ce faire, l’IA tiendra compte d’un e-mail précédent, pour demander le remboursement d’un vol annulé, par exemple. Il est possible d’agir sur le style rédactionnel ou la longueur du contenu, de façon à actualiser le « mail type » qui a été généré.

Immersive View : Google Maps dopé à l’IA

Immersive View donnera aux utilisateurs de Maps un moyen de découvrir et de préparer un itinéraire à travers des visuels 3D générés par l’IA. Cette nouvelle fonctionnalité extraira notamment des informations sur la qualité de l’air et la météo.

Google Photos & Magic Editor pour retoucher vos images

D’après Google, 1,7 milliard d’images sont modifiées chaque mois dans Google Photos. Les progrès de l’IA démontrent de nouvelles avancées dans l’automatisation de la retouche d’images rapide, grâce à la fonctionnalité Magic Eraser. Cette fonctionnalité utilise la photographie computationnelle, alimentée par l’IA, pour déplacer ou supprimer un élément d’une photo, par exemple. Google a précisé qu’il serait possible d’en faire encore davantage plus tard dans l’année, grâce à une combinaison de la compréhension sémantique et de l’IA générative.

Le nouveau modèle de langage PaLM 2

Toutes les fonctionnalités présentées reposent sur le tout nouveau modèle de grand langage à usage général (LLM) construit par Google : PaLM 2. Celui-ci peut générer une grande variété de textes à la façon d’un humain, en réponse à une entrée humaine.

PaLM 2 est compétent en mathématiques, en développement de logiciels, en raisonnement de traduction linguistique et en génération de langage naturel. « C’est mieux que nos précédents modèles de langage à la pointe de la technologie », a déclaré Zoubin Ghahramani, vice-président de Google DeepMind, lors d’une conférence de presse ayant eu lieu plus tôt dans la semaine. Pour rappel, Google a annoncé le modèle LaMDA en 2021 et le modèle PaLM, plus puissant, en 2022.

25 produits Google utilisent désormais PaLM 2, a-t-il déclaré, ajoutant qu’une version allégée pouvait fonctionner sur un appareil mobile.

Et le Search dans tout ça ?

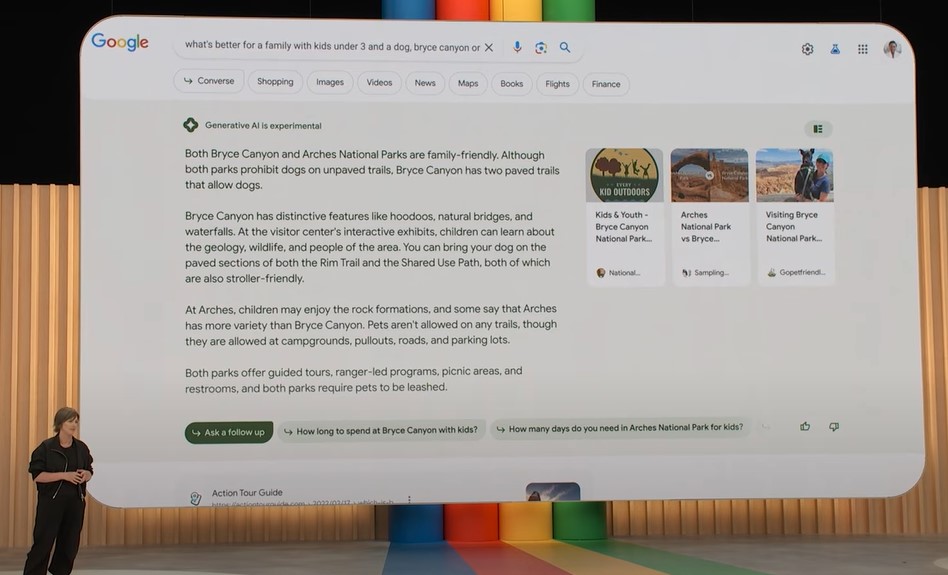

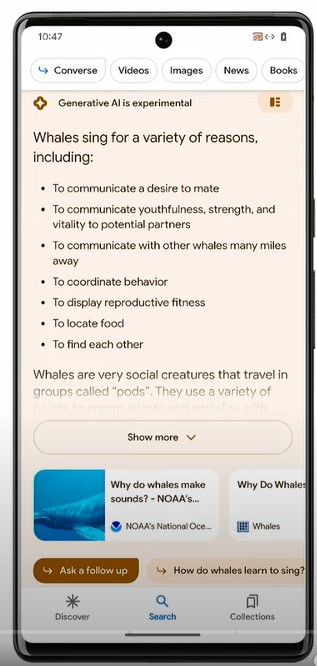

Search Generative Experience, ou SGE

« Une nouvelle ère commence pour le Search » : c’est ce que l’on vous annonçait dans l’une des conférences organisées pour les 15 ans de l’agence WAM et on ne s’est pas trompés ! Google a enfin montré des fonctionnalités d’IA génératives dignes de ce nom avec Search Generative Experience (SGE). SGE sera capable de synthétiser les résultats de recherche à partir de requêtes complexes.

Ces réponses « instantanées », s’afficheront prioritairement pour des demandes informationnelles et prendront la forme d’un gros encart de couleur. Elles synthétiseront ce que les internautes ont besoin de savoir sur le sujet demandé. La taille et l’emplacement de cet encart relèguent ainsi les résultats classiques assez bas dans la page de résultats de recherche. On retient surtout que la réponse générée intègre directement des liens pour aller plus loin. Il s’agit là de nouvelles opportunités de placement pour les SEO et les marques.

Concernant les recherches de produits, Google a précisé qu’il fondait ses réponses sur son Shopping Graph. Ce dernier compte plus de 35 milliards de listes de produits et se présente comme l’ensemble de données le plus complet au monde sur les produits, les vendeurs, les marques, les avis et les stocks. Google a précisé que chaque heure, plus de 1,8 milliard d’informations sont actualisées dans Shopping Graph, de façon à donner aux utilisateurs des résultats récents et fiables.

SGE sera disponible pour les utilisateurs de Labs au cours des « prochaines semaines », et les utilisateurs pourront y accéder en appuyant sur l’icône Labs dans l’application Google ou dans la version bureau de Google Chrome. On ne sait pas quand il sera disponible pour tout le monde.

Comme beaucoup d’autres fonctionnalités présentées par les dirigeants de Google lors de l’événement, l’accent est mis sur l’intégration, avec d’autres produits Google et avec l’index de recherche de Google.

Bard

Google a annoncé que son chatbot alimenté par l’IA est désormais accessible à tous (en anglais), que l’on figure ou non sur la liste d’attente. Une multitude de nouvelles fonctionnalités, telles que la prise en charge du japonais et du coréen, et un moyen plus simple d’exporter le texte généré vers Google Docs et Gmail ont été présentés.

- Désormais, Google ouvre l’accès au grand public, en le diffusant dans plus de 180 pays et territoires.

- Google a déplacé Bard vers le nouveau grand modèle de langage PaLM 2 pour fournir des réponses plus intelligentes aux questions des utilisateurs.

- Bard sera en mesure de répondre aux requêtes en anglais, en japonais et en coréen, et Google étendra bientôt la disponibilité aux 40 principales langues (dont le français), a déclaré Jack Krawczyk, responsable produit Bard chez Google.

- Google prend son temps pour ouvrir l’accès à Bard en raison d’un engagement envers la responsabilité et l’alignement de l’IA, et de la conscience des limites des grands modèles de langage qui alimentent les chatbots comme Bard et ChatGPT.

- Bard inclura bientôt des images dans ses réponses et, dans les prochains mois, Google facilitera l’envoi d’images au chatbot via l’outil Google Lens. Par exemple, « une personne peut pointer un smartphone vers un tiroir plein de fournitures d’art et d’artisanat et demander ce que l’on peut faire avec ».

- Au fil du temps, Bard pourra intégrer des informations de Google Maps, Google Docs, Google Sheets et Gmail dans les conversations. Bard sera également en mesure d’afficher des réponses avec l’aide d’outils tiers, tels qu’Adobe.

- Les intégrations avec les applications Spotify, Walmart, Redfin, Uber Eats, Tripadvisor et ZipRecruiter apparaîtront également dans quelque temps, a déclaré la vice-présidente de Google, Sissie Hsiao.

Avec Perspectives, trouvez des informations utiles sur les forums et les médias sociaux

Dans les semaines à venir, Google a précisé que lorsqu’une recherche trouvera sa solution dans les réponses générés par d’autres utilisateurs, Perspectives apparaîtra en haut des résultats de recherche. Un clic sur ce filtre affichera des vidéos longues et courtes, des images et des messages écrits partagés par les utilisateurs de forums de discussion (comme Reddit), des sites de questions-réponses (comme Quora) et des plateformes de médias sociaux.

Google s’engage également à fournir plus de détails sur les créateurs de ce contenu, tels que leur nom, leur photo de profil ou des informations sur la popularité de leur contenu.

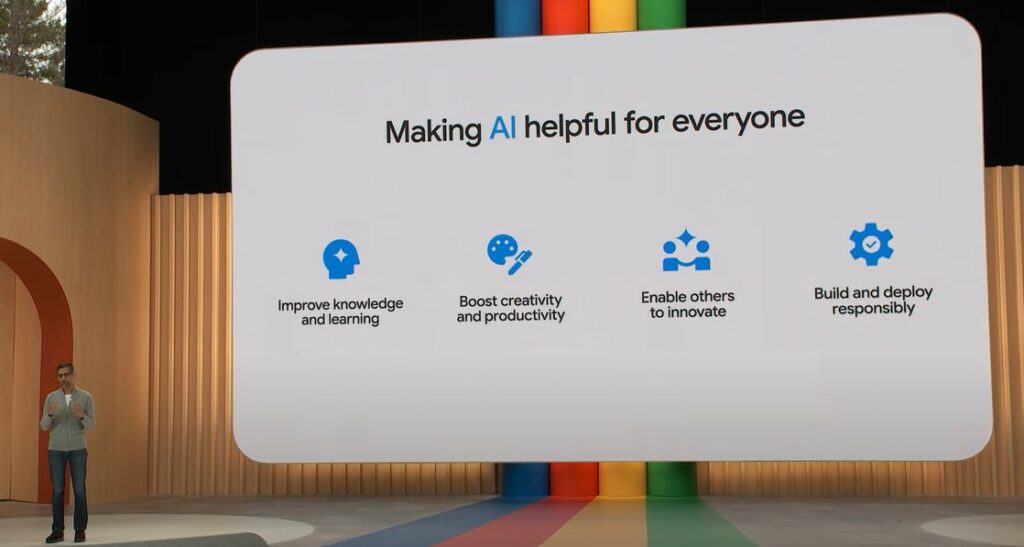

La mission de Google ne change pas, elle s’adapte avec l’IA

Google veut mener une mission de fond :rendre les connaissances du monde accessibles à tous et faire en sorte qu’elles soient utilisables.

Avec l’apport de l’IA, Google ajoute 4 grandes thématiques à ses missions :

- améliorer les connaissances et l’apprentissage ;

- booster la créativité et la productivité ;

- aider les entreprises et les développeurs à créer leurs propres activités ;

- déployer et construire une IA de manière responsable.

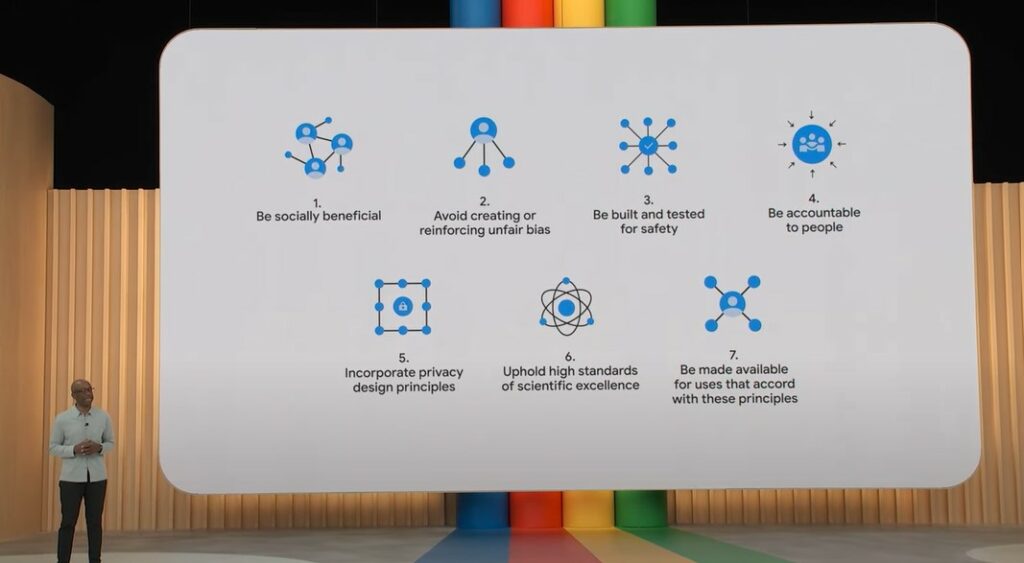

Google : l’acteur le plus responsable dans l’IA ?

Google a rappelé l’importance de la responsabilité, qui accompagne le déploiement d’outils puissants basés sur l’IA, lors d’une intervention de 10 min. Voici les principes de Google sur la question :

Google annonce ainsi créer des outils pour aider les internautes à évaluer l’information mise à leur disposition et savoir s’ils peuvent s’y fier.

Le côté ambitieux des avancées de Google en matière d’IA est souvent rattrapé par la volonté de la firme de se montrer responsable dans le développement de ses nouvelles fonctionnalités. Le traducteur vocal de vidéos en est un exemple. Il s’agit d’une fonctionnalité très intéressante, malgré un possible détournement à des fins de désinformation, qui pourrait la rendre très préjudiciable. Google a également évoqué le fait de n’avoir jamais commercialisé certaines avancées majeures, dont la reconnaissance d’images, car elle peut être détournée pour de la reconnaissance faciale, par exemple.

C’est pourquoi Google prend aujourd’hui beaucoup de précautions pour déployer ses outils ou, du moins, le laisse entendre.

Google a également rappelé que tous les plus grands LLM, dont OpenAI, utilisent le standard de Google Perspective AI pour aider à évaluer la toxicité des réponses générées. Une façon pour Google de justifier son retard par l’attention portée à chaque fonctionnalité développée.

Détecter les images générées par l’IA via les metadata

Toujours en matière de responsabilité, Google a précisé que toutes les images qui seront générées avec ses outils contiendront des metadata affichant clairement qu’un visuel n’est pas issu du réel. C’était une réponse attendue face à la prolifération d’images déformant la réalité depuis le lancement d’Open AI, par exemple, et contribuant à la désinformation sur le web. À l’avenir, les créateurs d’images pourront eux aussi utiliser cette metadata pour indiquer que leurs images ont été générées par l’IA.

Pour retrouver en détail les informations officielles de Google, rendez-vous sur cet article. L’agence WAM prépare de son côté un article qui reviendra plus spécifiquement sur les fonctionnalités Search annoncées lors de ce Google I/O 2023, comme SGE, Perspectives et Bard. Pour ne rien louper, inscrivez-vous à notre newsletter !