Analyse de logs : que faire et pourquoi ?

Qu’est-ce que les logs ?

Lorsque l’on parle d’analyse de logs, nous parlons de l’analyse des fichiers de logs se trouvant sur les serveurs d’un site web. Ces logs sont une sorte d’historique géant contenant de nombreuses informations.

Parmi ces informations, on trouve par exemple :

- l’adresse IP à l’origine de la demande au serveur ;

- le type de la demande (GET ou POST) ;

- le statut code HTTP de la ressource demandée (200, 301, 404, etc.) ;

- la date et l’heure à laquelle la demande a été faite…

À chaque fois que le serveur est sollicité par un internaute ou par un robot (nous en parlerons plus tard), celui-ci ajoute une (ou des, selon les cas) nouvelle ligne dans son historique, que l’on appelle un « hit ». Cela représente un très grand nombre de lignes, c’est pourquoi il est indispensable d’utiliser un outil d’analyse de logs afin de pouvoir étudier ces données.

Qu’est-ce que le budget crawl ?

Crawl : de quoi s’agit-il ?

En référencement naturel, le « crawl » représente l’action d’exploration d’un site par les moteurs de recherche via des logiciels appelés « robots », « bots » ou encore « spiders ». La mission de ces robots est d’explorer l’ensemble des pages et liens présents sur Internet.

À l’échelle d’un site, les robots des moteurs de recherche vont passer de lien en lien et analyser l’ensemble des contenus présents sur les pages du site. Leur objectif : ajouter toutes ces données dans leurs index et les proposer aux internautes.

Cette vidéo, qui date un peu mais reste toujours pertinente, vous aidera à y voir plus clair si vous n’êtes pas familier du sujet :

Cette phase de crawl et d’indexation ne s’arrête pas là. Afin de proposer les contenus les plus à jour possible, les moteurs de recherche vont envoyer des robots quotidiennement sur un site, parfois même plusieurs fois sur une même page, afin d’indexer les dernières versions des contenus.

Cela représente des centaines ou des milliers de visites quotidiennes uniquement par des robots, en fonction de la taille du site. C’est pourquoi la notion de budget crawl est importante.

Et donc le budget crawl, c’est quoi ?

Pour faire simple, le budget crawl représente le nombre de hits maximum alloué quotidiennement par les moteurs de recherche pour l’exploration d’un site (découverte de nouvelles pages, mise à jour d’un contenu, etc.) via les robots.

Ce nombre n’est pas le même pour tous les sites et dépend de nombreux facteurs, comme :

- le temps de chargement des pages ;

- la profondeur de l’arborescence du site ;

- la fréquence de mise à jour du site ;

- la qualité d’un contenu…

C’est là que l’analyse de logs rentre en jeu !

Focus sur l’analyse de logs

À quoi sert l’analyse des logs en SEO ?

L’objectif d’une analyse de logs est d’optimiser au maximum les hits du budget crawl disponibles pour un site. Cela permet en effet de mieux dépenser le « temps » alloué par les robots vers les pages à forte valeur ajoutée pour le SEO.

Pour ce faire, on passe à la loupe le comportement de Google en étudiant son comportement via un outil d’analyse de logs. Cet outil permettra de découvrir de précieuses informations, qu’il serait quasi impossible d’obtenir sans l’analyse des fichiers de logs (les données du récent rapport de la Google Search Console dédié au sujet sont encore assez peu fiables au moment où nous écrivons ces lignes).

Comment faire son analyse de logs ?

Pour effectuer une analyse de logs, vous devez avoir accès aux logs serveurs du site que vous souhaitez analyser. Il vous faut également un outil permettant d’extraire, de visualiser et de manipuler ces logs. Il existe de nombreux outils à disposition :

Comment l’analyse de logs peut aider à optimiser le budget crawl ?

L’étape de la catégorisation

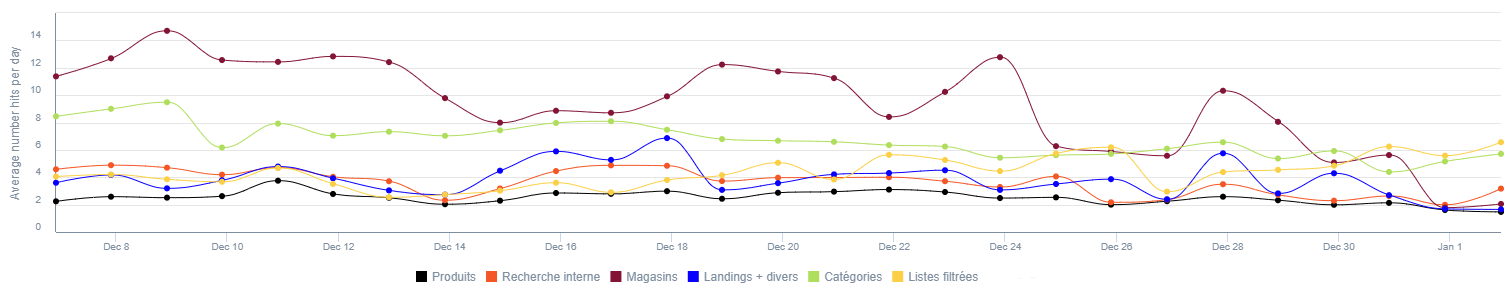

Une fois les logs importés dans un outil, la première étape est de catégoriser en groupe de pages les URL d’un site afin d’avoir une vision macro des hits sur chacun des groupes. Ces informations sont précieuses car elles sont à la base de la stratégie d’optimisation du budget crawl.

Il est ainsi possible de visualiser rapidement si les robots passent plus de temps sur les groupes de pages intéressants pour le SEO ou sur d’autres pages qui ont peu ou pas d’intérêt pour votre stratégie de référencement naturel.

La fréquence d’exploration

Grâce à l’analyse de logs, vous pouvez connaître la fréquence d’exploration des pages d’un site. Cette donnée est importante car elle permet de connaître le nombre de fois qu’un robot vient explorer vos pages selon la période analysée. Cet indicateur vous permet donc de savoir quelles sont les pages recevant le plus de visites des robots ou, au contraire, celles qui en reçoivent moins.

La fréquence d’exploration vous permettra également d’évaluer la qualité de vos optimisations SEO. Si vous voyez une augmentation des hits sur les pages optimisées, c’est que votre optimisation fonctionne et que les robots viennent plus souvent observer vos pages.

La fenêtre de crawl

Cet indicateur permet de connaître le nombre de jours nécessaires, en moyenne, pour que l’ensemble des pages d’un site soient crawlées au moins une fois par un robot.

Cette information est particulièrement importante pour les sites marchands ou les médias. En effet, en connaissant sa fenêtre de crawl, il est possible de déterminer le moment idéal pour publier un article ou, pour les sites e-commerce, de mettre en ligne des pages pour les soldes, par exemple, afin d’être visible au bon moment.

On parle ici quasi exclusivement aux détenteurs de gros sites (fort volume d’URL), les petits n’étant pas vraiment concernés par la notion de budget de crawl. Il y a d’ailleurs d’excellentes ressources fournies par Google himself dans son centre d’aide pour les webmasters (Search Central) ici et ici.

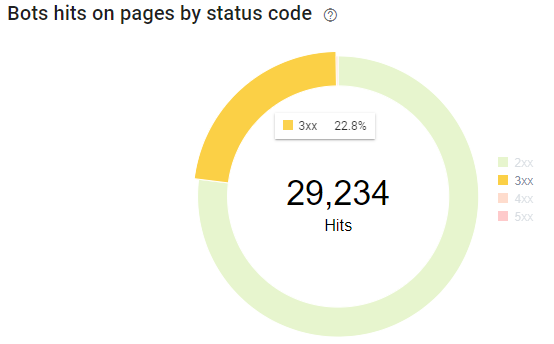

Les codes HTTP

L’objectif de l’analyse des codes HTTP est de réduire au maximum le nombre de hits sur des pages répondant en erreurs 404, 500 ou comportant des redirections. Il est important de noter que les codes HTTP remontés par l’analyse de logs ne sont pas les mêmes que ceux remontées par un crawler.

Le crawler va uniquement remonter les codes HTTP des pages maillées dans le site, alors que l’analyse de logs va également remonter les données des pages connues par les moteurs de recherche mais qui ne sont pas maillées.

Sur l’image ci-dessus, nous constatons qu’en l’espace d’un mois, 29 234 hits (soit 22,8 % des hits) ont été réalisés sur des pages contenant une redirection. Il faut donc au maximum limiter les hits vers ce type de pages afin d’orienter les robots vers des pages répondant en 200 (ici il faudra donc nettoyer les pages maillées dans votre site, le reste : vous ne pourrez pas y faire grand chose en dehors de changer le statut en 410 pour des pages qui n’ont plus d’intérêt à vos yeux).

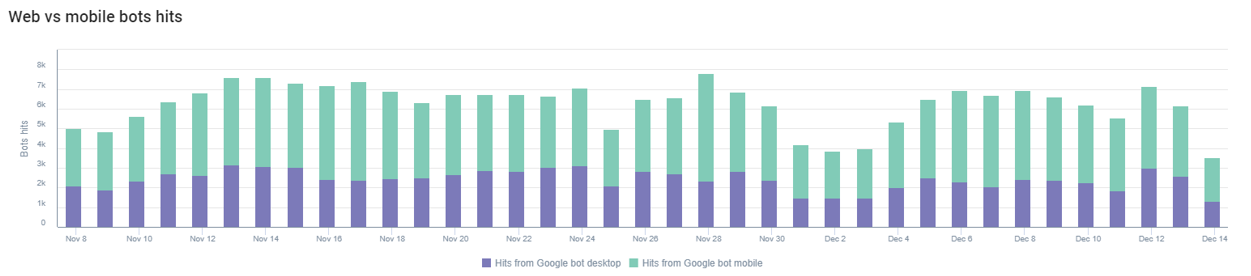

Analyse des bots mobile vs. desktop

Les moteurs de recherche envoient différents types de robots analyser les pages des sites Internet. Grâce à l’analyse de logs, il est possible d’identifier ces robots et d’analyser leurs comportements. Google dispose par exemple de plusieurs types de robots :

- Googlebot Image (analyse les images) ;

- Googlebot News ;

- Googlebot Desktop ;

- Googlebot Mobile…

Analyser les données des bots mobile et desktop s’avère particulièrement intéressant lorsque l’on sait que Google a mis en place l’index mobile-first depuis quelques années (et qui devrait être en place sur 100 % des sites en mars 2021). Si vous obtenez plus de hits provenant du Googlebot Mobile que Dekstop, cela signifie probablement que le site est passé dans l’index mobile-first (c’est indiqué sur la Search Console si vous vous posez la question). Il faudra donc s’assurer que tous vos contenus soient bien accessibles sur la version mobile et que leur maillage soit identique à celui de la version desktop !

Détecter les pages orphelines

Grâce à l’union des données d’un crawler (outil simulant le passage d’un robot en parcourant les URL d’un site) et de l’analyse de logs, il est possible de détecter des pages orphelines. C’est-à-dire, des pages qui ne sont pas maillées dans le site (qui n’ont pas de liens internes entrants) mais que les moteurs de recherche connaissent.

Il est important d’identifier ces pages car elles peuvent potentiellement être importantes pour le SEO. Si elles ne sont pas maillées correctement dans le site, alors il sera extrêmement compliqué d’être visible sur ces pages. Si, au contraire, ces pages n’ont pas d’intérêt pour le référencement du site, alors vous perdez de précieux hits qui pourraient vous servir sur d’autres pages.

Détecter les contenus dupliqués

La duplication des contenus peut représenter un fort risque pour le budget de crawl d’un site. Nous pouvons prendre l’exemple d’un site e-commerce qui dispose de nombreuses catégories de produits qui peuvent être filtrées, ou encore différentes pages pour un même produit dont seule la taille change.

Si ces différents cas de figure ne sont pas optimisés pour le référencement naturel, cela peut représenter un très grand nombre de pages dupliquées, et donc un gouffre dans lequel les robots peuvent s’enfoncer. Cela aura pour effet d’impacter le budget de crawl du site, puisque l’exploration concernera de nombreuses pages non prioritaires pour votre SEO.

Quand peut-on mener une analyse de logs ?

Lors d’un audit

L’analyse de logs peut être utilisée en « one shot » pour faire l’audit d’un site. Lorsque vous avez récupéré suffisamment de données (il faut que les robots aient visité toutes les pages du site au moins une fois), vous pourrez utiliser l’analyse de logs pour passer en revue les différents points cités précédemment et connaître les forces et les faiblesses du site.

On considère chez WAM que 45 jours est une période assez longue pour un site plutôt statique afin que Google passe partout. Si tel n’est pas le cas alors… à vous d’en tirer les conclusions. Pensez à réfléchir à votre cas personnel, peut être que vos produits restent en ligne seulement quelques jours : la période d’analyse devrait donc être ajustée.

Pour un monitoring technique

L’analyse de logs peut également être utilisée pour faire le monitoring technique d’un site. L’objectif est de détecter des anomalies durant la période de monitoring. Grâce à un suivi régulier, vous pouvez voir si un grand nombre de nouvelles pages sont observées par les robots. Cela peut signifier que les facettes du site se sont ouvertes et que les moteurs de recherche ont accès à ces pages. Il vous faudra alors déterminer si cette ouverture est bonne pour votre référencement, ou non.

Cette phase de monitoring permet également de voir si les actions que vous avez mises en place ont des effets sur les robots.

Lors d’une refonte

L’analyse de logs peut être utile en amont et en aval d’une refonte de site, pour observer le comportement des robots. Cette analyse permet de :

- voir si votre maillage est plus efficace qu’avant la refonte ;

- détecter des problématiques techniques (redirection, erreurs 404, erreurs 500 etc.) ;

- comparer les temps de chargement des pages ;

- comparer le taux de crawl ;

- comparer le nombre de pages orphelines ;

- analyser la profondeur des pages…

En conclusion, l’analyse de logs est un outil intéressant pour orienter la stratégie SEO d’un site. Elle permet d’obtenir des informations précieuses qu’il serait impossible d’obtenir sans. C’est également un potentiel moyen d’imaginer un ROI aux actions d’optimisations du SEO qui sont mises en place.

L’analyse de logs peut également être utilisée avec les données d’un crawler pour obtenir encore plus d’informations entre les pages maillées dans le site et les pages connues par les moteurs de recherche.

N’hésitez pas à partager cet article sur vos réseaux préférés !