Le Search en pleine mutation : de Google aux LLM

Les chiffres parlent d’eux-mêmes : 95 % des utilisateurs de ChatGPT visitent encore Google, tandis que seulement 14 % des utilisateurs Google se tournent vers ChatGPT (source : searchengineland.com). Ces données de septembre 2025 révèlent un écart significatif par rapport au début de l’année, démontrant une belle évolution des IA. Comme l’explique Maxime Bonnefond : « En termes de recherche, à ce jour, l’IA conversationnelle ne va pas remplacer le Search, mais va le compléter et élargir les usages. »

Pourtant, l’urgence est là. « Vos prospects et clients ne trouvent plus leurs réponses uniquement sur Google. Ils interrogent déjà ChatGPT, Perplexity, Gemini et autres IA génératives », poursuit-il. Pour les professionnels du marketing digital, l’enjeu consiste désormais à apparaître dans les réponses générées par ces intelligences artificielles, tout en maintenant leur « performance SEO classique ».

Les freins à une roadmap SEO efficace

Les équipes marketing sont aujourd’hui confrontées à plusieurs obstacles structurels majeurs :

- des collaborateurs trop peu sensibilisés aux enjeux du référencement naturel ;

- des CMS avec des limitations techniques importantes ;

- une culture Test & Learn encore timide ;

- et une agilité en décalage avec le rythme effréné des mises à jour algorithmiques.

Ces constats ont été largement partagés par les participants lors de l’échange.

Ces freins s’amplifient avec la poussée de l’IA Search. Les outils de suivi de visibilité peinent à capter les performances dans les environnements IA, et les équipes manquent encore de formation et de sensibilisation sur ces nouvelles problématiques. La solution ? Adopter une approche Test & Learn combinée à des solutions techniques flexibles comme le EdgeSEO.

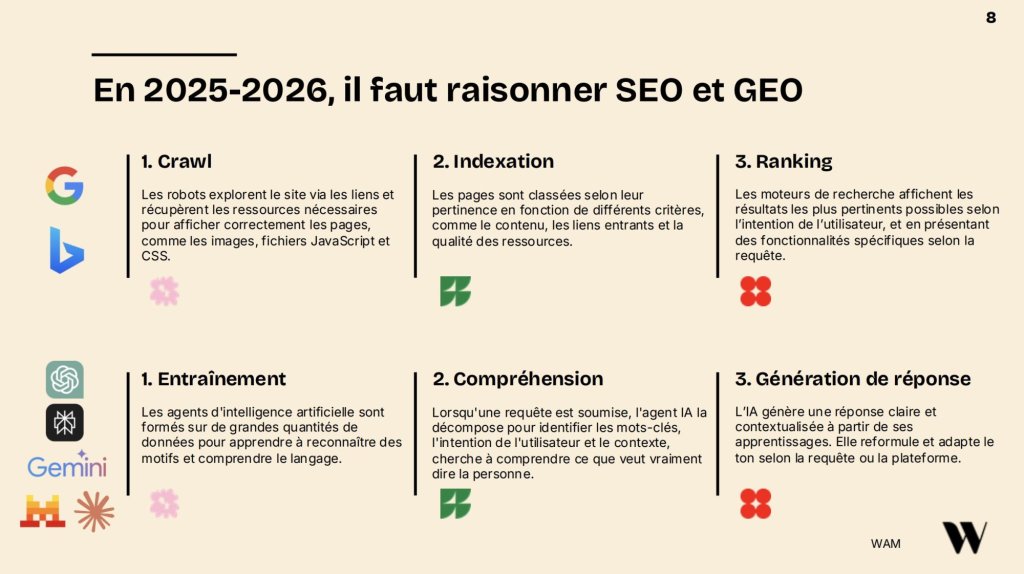

Comprendre le GEO : comment les LLM génèrent leurs réponses

Là où le SEO traditionnel repose sur trois piliers (crawl, indexation, ranking), le GEO fonctionne avec quelques différences notables : entraînement, compréhension et génération de réponse. Les agents d’IA s’appuient sur des bases de données comme Common Crawl et, massivement, sur les moteurs de recherche traditionnels pour leur apprentissage.

Les prérequis techniques restent similaires au SEO, mais se renforcent considérablement :

- Rendering : le JavaScript devient l’ennemi des LLM. Un site full JS est pratiquement invisible pour les IA, qui ne savent pas digérer ce type de contenu.

- Gestion des bots : les bots IA (Meta, Perplexity, Claude, Gemini) saturent les serveurs. Sur certains sites à fort volume, leur trafic dépasse désormais celui de Googlebot.

- Structure : les algorithmes des LLM restent relativement immatures. Une structure claire et simple convient parfaitement à leur compréhension actuelle.

- Web performances : une étude sur 2 138 sites démontre que les pages avec un TTFB inférieur à 200ms obtiennent +22 % de citations dans les extraits IA.

EdgeSEO : la solution pour reprendre le contrôle

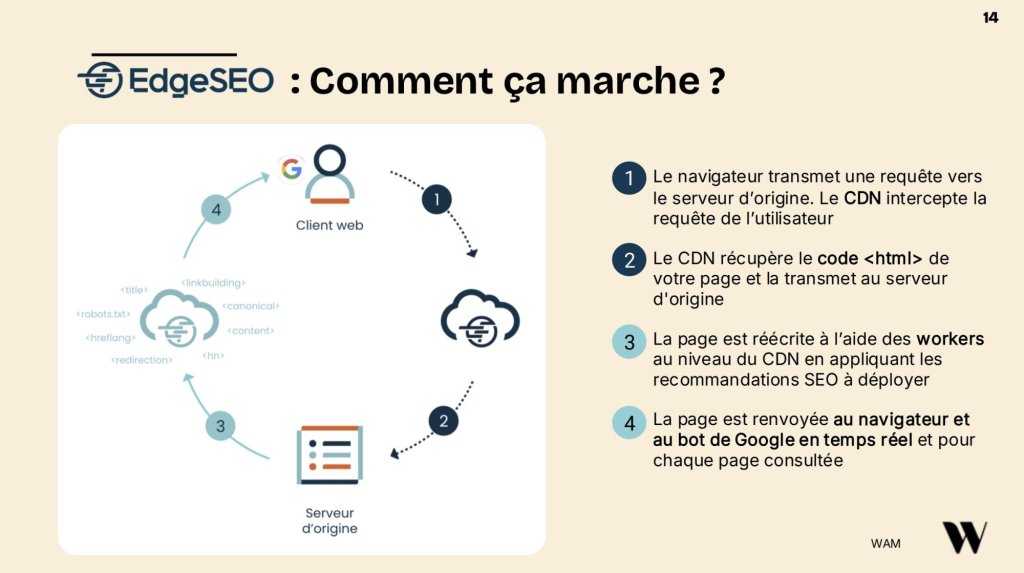

Face à ces défis, Romain Thierry présente le EdgeSEO, un concept popularisé en 2018 par Dan Taylor. Cette technologie permet de modifier le code HTML côté serveur, « at the edge », pour déployer des recommandations SEO de manière autonome et instantanée.

L’EdgeSEO offre une opportunité unique aux consultants SEO : modifier le code source HTML directement côté serveur, sans passer par des modifications en JavaScript côté client. Cette approche est fondamentale car elle préserve les performances web, contrairement aux solutions d’AB Testing traditionnelles qui dégradent le temps de chargement.

Le principe : EdgeSEO se positionne entre le navigateur du client et le serveur d’origine, intercepte le code HTML, applique les configurations SEO souhaitées, puis renvoie la page optimisée aux utilisateurs et aux bots en temps réel.

Cette solution transforme le quotidien des équipes SEO en leur redonnant l’autonomie nécessaire pour déployer en continu. Romain Thierry y voit « votre laboratoire de recherche, c’est ce qui vous fait toujours garder une longueur d’avance sur vos concurrents » grâce à la vélocité apportée au Test & Learn.

5 use cases concrets pour gagner en visibilité LLM

1. Résoudre le problème JavaScript

Un client e-commerce, bien positionné 2e sur Google pour « t-shirt homme bleu », était invisible sur ChatGPT. La raison ? Un site full JavaScript que les LLM ne peuvent pas lire. Maxime Bonnefond est catégorique : « Le JavaScript n’est pas du tout digeste pour les LLM » car l’IA ne parvient pas à identifier le contenu présent sur ces pages. La solution passe par une HTMLisation maximale et le recours au rendu côté serveur (SSR) pour le contenu stratégique, le JavaScript restant l’ennemi numéro un de la visibilité dans les LLM.

2. Maîtriser les bots IA

Sur un site client de +10 millions de pages, les serveurs ont saturé à plusieurs reprises. En cause : les bots IA qui aspirent massivement le contenu. « On s’est rendu compte chez certains de nos clients que certaines pages tombaient puisque finalement il y avait une surfréquentation des bots », constate Maxime.

Plutôt que de bloquer aveuglément, la bonne pratique consiste à analyser les logs serveurs pour identifier les bots problématiques, puis décider en concertation avec toutes les équipes métiers s’il faut les bloquer. La mise en place d’un système d’alerting devient indispensable. Avec EdgeSEO, cette mise à jour du robots.txt se fait de manière autonome.

3. Créer un fichier llms.txt

Ce fichier Markdown, bien que non standardisé, commence à être adopté par des acteurs majeurs comme Cloudflare. Romain Thierry encourage l’expérimentation : « Testez, vous verrez, et peut-être que dans un an, ce sera enterré ou adopté, on ne sait pas. »

Il anticipe même son utilité future avec le web agentique, où les agents IA dialogueront entre eux et pourront identifier rapidement les contenus pertinents d’un site. Ce fichier permet d’apporter un cadre aux LLM, en présentant les informations de manière structurée pour maximiser les chances d’être cité et mentionné dans les réponses générées, tout en contrôlant la façon dont le contenu est restitué.

4. Structurer pour l’extractibilité

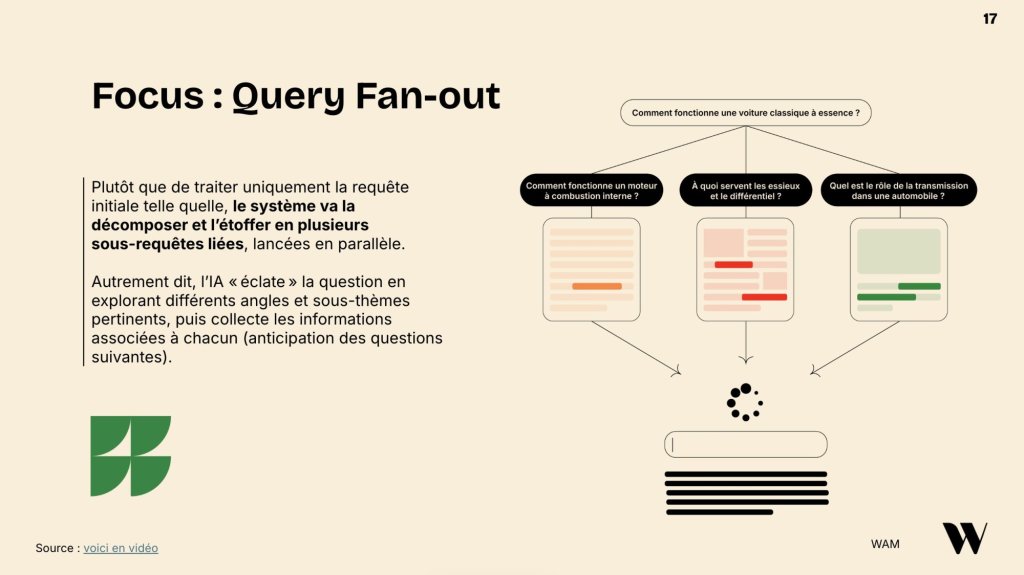

Les LLM fonctionnent sur le principe du Query Fan-Out : ils divisent une requête en multiples sous-requêtes. Les contenus doivent donc être pensés comme une addition de blocs indépendants et extrayables : listes à puces, FAQ, tableaux comparatifs, paragraphes autonomes avec un résumé en haut de page.

5. Optimiser les Core Web Vitals

Les pages avec un CLS inférieur à 0,1 enregistrent +29,8 % d’inclusion dans les réponses génératives. Une page légère (HTML < 1 Mo) évite 18 % d’abandons de crawl. Les web performances ne sont plus seulement un critère UX, elles impactent directement la visibilité dans les LLM.

Test & Learn : l’impératif stratégique

Dan Taylor le résume parfaitement dans une citation reprise par Maxime : plutôt que de se demander si le SEO est mort, la vraie question est de savoir comment s’adapter à un contexte IA mouvant et incertain.

Dans un environnement où chaque assistant IA fonctionne différemment et évolue rapidement, la culture du Test & Learn devient indispensable. Les assistants doivent être considérés individuellement car ils n’utilisent pas les mêmes méthodes d’apprentissage et de restitution. L’approche expérimentale permet de valider rapidement ce qui fonctionne avant de déployer à grande échelle.

L’EdgeSEO permet justement cette agilité : déployer une optimisation en une journée maximum, mesurer son impact, ajuster si nécessaire. Cette vélocité transforme la pratique du SEO technique et redonne de l’autonomie aux consultants, sans dépendre des cycles de développement parfois longs de plusieurs mois.

Le SEO est-il (encore) mort ?

La réponse de Maxime Bonnefond est catégorique : non, mais les méthodes actuelles doivent évoluer. Les fondamentaux du SEO restent valables et constituent même les bases du GEO. Le consultant insiste : en 2026, il faudra penser SEO et GEO simultanément.

L’importance des fondations techniques se renforce avec l’émergence des LLM. Les web performances, le traitement du JavaScript, la structure des pages deviennent encore plus décisifs. L’EdgeSEO offre justement la solution pour aller plus loin, gagner en réactivité et se démarquer de la concurrence sur son secteur.

Notre intervenant

Maxime Bonnefond

De formation marketing, c’est en arrivant au sein de l’agence WAM en 2015 que j’ai pu m’initier au côté technique du SEO. Aujourd’hui, cette double compétence me permet d’apporter mon expertise à nos clients grands comptes en tant que chef de projet mais aussi de partager mes connaissances avec mes collègues comme directeur technique SEO. Sinon je suis un grand fan de musique et le jeudi soir je peux pas, j’ai batuc’ !

Notre invité

Romain Thierry

Product Manager chez Fasterize

Restons connectés

Dites-nous ce que l’on peut faire pour vous !

Parce qu’une vraie discussion vaut mille briefs PDF, contactez-nous pour échanger de vive voix sur votre autorité digitale, vos besoins, votre projet. Mieux ? Venez nous voir en vrai dans notre agence à Lyon ou à Mulhouse.